Bernard Ourghanlian, grand invité de la Semaine de la Recherche & de l’Innovation 2020 de l’EPITA

Du 14 au 18 septembre 2020, l’EPITA a organisé la nouvelle édition de sa Semaine de la Recherche & de l’Innovation à destination de ses étudiants de 2e année du campus de Paris et en régions. Nourrie d’ateliers et conférences permettant de mieux appréhender les enjeux de la recherche et ses défis, cette semaine a surtout offert aux futurs ingénieurs la possibilité de rencontrer de nombreux experts en cryptographie, intelligence artificielle ou encore imagerie médicale, parmi lesquels des enseignants-chercheurs de l’école, plusieurs Anciens et des personnalités extérieures de premier plan du monde des nouvelles technologies.

Traditionnellement, chaque Semaine de la Recherche & de l’Innovation de l’EPITA est inaugurée par un grand invité prestigieux. Ainsi, après Cédric O, secrétaire d’État chargé du Numérique et Philippe Bournhonesque, Chief Technical Officer (CTO) d’IBM France, l’école d’ingénieurs a pu cette année compter sur la présence de Bernard Ourghanlian, directeur Technique et Sécurité de Microsoft France, pour lancer cette édition 2020. Une intervention qui a permis d’aborder de multiples sujets passionnants, de la place de l’éthique dans la recherche aux perspectives offertes par l’informatique quantique. L’EPITA a profité de l’occasion pour s’entretenir avec ce grand professionnel, « boulimique de la connaissance » et du partage.

Bernard Ourghanlian

Pourquoi avoir accepté d’inaugurer cette nouvelle Semaine de la Recherche & de l’Innovation de l’EPITA ?

Bernard Ourghanlian : La première raison, c’est que j’ai commencé ma carrière comme enseignant-chercheur. J’ai enseigné au collège, au lycée et en IUT, en Master 2, dans différents établissements, notamment à Centrale et dans une école du Groupe IONIS, l’ESME Sudria… D’une manière générale, j’ai enseigné pendant une très longue partie de ma carrière. Alors, évidemment, c’était au début un job à plein temps, puis, petit à petit, c’est devenu un job de complément, dont l’objectif n’était pas de réaliser le moindre profit mais de garder un contact avec les étudiants. Au fond, j’aime bien l’enseignement. Et pour être honnête, la seule chose qui me barbe dans ce domaine est la même qui m’a finalement poussé à évoluer rapidement ailleurs dans ma carrière : la répétition. Pour moi qui suis mathématicien de formation, je trouve que l’enseignement est trop souvent répétitif. L’idée d’avoir à répéter la même chose deux années de suite est quelque chose qui m’insupporte. Dans les écoles d’ingénieurs par exemple, les mathématiques que l’on enseigne ont, pour l’essentiel, toutes été inventées avant le 20e siècle – bon, j’exagère un peu, mais je ne suis pas très loin de la vérité. Cela vous condamne à vous répéter et, forcément, ça peut lasser. Ce fut mon cas. Par contre, l’idée de pouvoir interagir avec des étudiants continue de me ravir. Cela me permet à la fois de comprendre leurs aspirations et leurs goûts, comment ils se préparent au monde de main, mais aussi, de temps en temps, de faire passer quelques messages sur un certain nombre de sujets qui me tiennent à cœur. J’étais donc absolument ravi de pouvoir m’adresser aux étudiants de l’EPITA à l’occasion de cette conférence.

Est-ce que c’est l’absence de répétition qui vous plaît aussi dans votre métier aujourd’hui ? Durant la conférence, on a bien vu que, chez Microsoft, vous suiviez des projets très variés, touchant à de nombreux domaines différents.

Oui. D’une certaine manière, on peut considérer que je suis un boulimique de la connaissance. Tout m’intéresse, y compris des domaines non scientifiques, comme la littérature, la philosophie, la sociologie… Je suis aussi un fou furieux de poésie, un musicien depuis toujours… Bref, je suis attiré par tout ce qui, d’une manière générale, me nourrit. J’ai besoin d’être nourri. Ce critère de répétition est capital pour moi dans le fait de choisir mon employeur. Je ne rejoindrais jamais un employeur qui ne pourrait pas m’alimenter continuellement. C’est pour cette raison que je suis resté chez Microsoft depuis toutes ces années : ici, les sujets sont en permanence nouveaux et l’innovation est pratiquement sans limite.

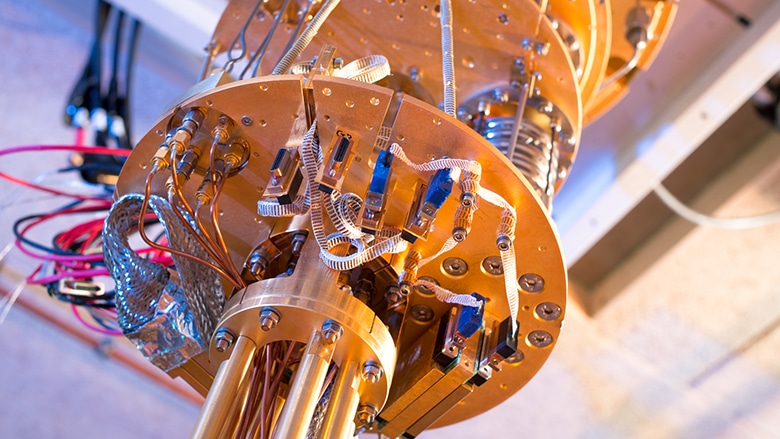

L’informatique quantique, un enjeu majeur pour la recherche

Cette appétence pour la connaissance, cette curiosité, c’est l’un des messages forts que vous avez adressé aux étudiants. Sans curiosité, on ne peut pas devenir un bon chercheur ni influer sur l’innovation ?

Il faut être curieux, c’est sûr. Il faut aussi avoir l’envie d’apprendre chaque jour. Si l’on n’apprend rien, c’est une journée perdue. Il faut donc être dans cette logique-là, mais pas seulement : il faut aussi être ouvert aux autres. En effet, il est assez rare que l’innovation se fasse dans la solitude, dans sa chambre – il existe bien entendu quelques contre-exemples, mais ces derniers sont extrêmement rares. Il faut être capable de travailler avec les autres. La curiosité, l’envie d’apprendre, de découvrir des choses nouvelles et de découvrir ce qu’on ne sait pas, cela reste le moteur principal de l’innovation. C’est même un moteur extrêmement puissant.

Quel est l’objectif de la recherche et l’innovation ? De parvenir à créer de nouveaux outils répondant à des besoins qui, parfois, n’existent pas encore ?

Oui, cela fait partie des raisons pour lesquelles nous innovons. Derrière l’innovation, il y a de la recherche. Et derrière la recherche, il y a cette idée d’une sorte de dichotomie qui pourrait exister entre la recherche fondamentale et la recherche appliquée. Moi, cette dichotomie, je ne l’aime pas du tout car, fondamentalement, elle n’est liée qu’à des questions de temporalité. Par exemple, Microsoft travaille sur l’ordinateur quantique depuis 1997 et je n’étais pas donc encore là quand Alexei Kitaev a écrit son premier papier sur l’ordinateur quantique topologique. Or, quand l’on invente, ce qui compte vraiment, c’est que l’invention puisse être utilisée. Et le jour où c’est le cas, cela devient une innovation : une innovation est une invention qui rencontre un usage. Tant que ce n’est pas utilisé, que les usages n’ont pas été trouvés, on reste dans le champ de l’invention, on n’entre pas encore dans celui de l’innovation. Derrière l’usage se retrouvent également plein de questions. Prenons la Covid-19, pour rester dans l’actualité : elle a nous permis, paradoxalement, d’apprendre énormément de choses sur le monde et sur nous-mêmes. D’une part, on a pu, le cas échéant, se poser tout un tas de questions sur le sens de notre vie et des sujets qui sont plutôt d’ordre philosophique. D’autre part, cela nous a aussi permis de nous rendre compte que travailler chez soi, travailler à distance n’allait pas de soi, à la fois pour des raisons sociologiques – typiquement, dans diverses entreprises, le télétravail reste encore difficile car cela remet en cause un certain nombre de pratiques managériales, en particulier celles fondées sur le fait que le manager est là pour surveiller que les gens viennent le matin, qu’ils repartent le soir, qu’ils ont bien fait leurs heures… Bref, tout un côté « comptage des heures » qui transmet l’idée qu’il faut être présent, arriver avant le chef, partir après lui, etc. Cela démontre un vrai sujet, celui de l’évolution du management qui n’a pas encore eu lieu. Au-delà de ça, on s’est aussi rendu compte que travailler de chez soi n’allait pas de soi aussi parce qu’on n’était pas forcément équipé et que ce n’était pas si simple, comme pour la garde des enfants. Quand on est deux à télétravailler se pose la question de la répartition des rôles au sein du foyer, de la famille, alors que cette question était déjà réglée avant, plus ou moins bien, plus ou moins équitablement. La situation a nécessité de revisiter tout cela. Et derrière ce télétravail plus ou moins forcé, énormément de chercheurs de Microsoft, plutôt des anthropologues et des sociologues, se sont penchés sur ce que ça voulait dire de vivre confiné et de faire du télétravail, pour se rendre compte que beaucoup de choses nécessitaient des améliorations. Cela soulevait des questions portant aussi bien sur l’équipement des gens à leur domicile – certaines personnes s’étaient installées sur leur petite table de leur salon et, au bout d’une heure, avaient le dos « cassé » – que sur la relation de couple, la relation parents-enfants, la quête de sens… De ce fait, énormément de questions qui se sont posées ne relevaient pas de la technologie pure.

Lors de sa conférence, Bernard Ourghanlian a présenté plusieurs projets menés au sein des laboratoires de Microsoft, dont le projet Emma

Microsoft et l’EPITA sont associées autour d’Impact AI (collectif de réflexion et d’action rassemblant des acteurs de l’IA). Pourquoi est-ce important pour un grand groupe d’être en lien avec un grand nombre d’institutions et de structures ?

Dans le cadre d’Impact AI, nous cherchons à nous poser des questions sur les impacts et les usages de l’IA, les freins et les questions éthiques, les sujets innovants… Nous sommes dans une logique où faire les choses de manière isolée n’aurait pas de sens : l’IA mobilise l’inconscient collectif (depuis 2001, l’Odyssée de l’espace ou Terminator) et s’est enrichie d’une certaine forme de crainte. Si l’on veut que ce sujet dépasse le cadre de l’invention pour se mettre vraiment au service d’un maximum de citoyens, il faut aller au-devant d’eux et ne pas rester dans son coin. Et ce n’est pas si simple. Voici un exemple typique de l’échec de l’innovation. On a considéré qu’Apple avait apporté une innovation très importante avec l’iPhone et l’iPad via son interface tactile. Mais Microsoft avait introduit un Tablet PC dès 2001. À l’époque, nous pensions qu’à travers l’utilisation d’un stylet, la possibilité d’utiliser l’écriture (y compris pour ceux qui écrivent très mal) allait constituer une nouvelle façon pour l’homme d’interagir avec la machine. Or, nous nous étions trompés en passant à côté d’un sujet : au lieu d’imaginer une interface avec laquelle on pourrait interagir avec ses doigts, on pensait que les gens allaient continuer à écrire avec un stylet. Cela aurait été pourtant pas très compliqué, mais nous n’avions pas imaginé le concept ! Typiquement, nous nous sommes trompés sur les scénarios d’usage, alors que nous avions sorti cet ordinateur près de cinq années avant les interfaces tactiles d’Apple. Cela montre combien il est important de comprendre comment une technologie va être utilisée avant même de l’introduire sur le marché. Car quand on invente, ce qui compte est comment va être utilisée cette invention. Encore une fois, une innovation, c’est une invention qui rencontre un usage.

Quelle est l’innovation qui vous a le plus marqué depuis ces 20 dernières années ?

L’intelligence artificielle. Pas tant que ce soit une vraie surprise, car j’ai connu l’IA pendant mes études, mais dans une vision très préliminaire fondée sur des règles. L’IA était un sujet passé de mode et, en ce sens, l’informatique est une succession de modes. Ainsi, elle passe son temps à alterner entre centralisation et décentralisation : les ordinateurs centraux ont fait place aux PC qui ont permis de décentraliser, puis le Web a recentralisé… On se rend compte que l’informatique n’échappe pas aux modes. L’IA a été une forme de bonne surprise : l’idée que l’on se mette à utiliser les statistiques et avoir une approche probabiliste sur la modélisation est quelque chose à laquelle je ne m’attendais pas nécessairement. Les progrès réalisés conjointement par les évolutions algorithmiques, les capacités de collecte de données et de calcul ont participé du renouveau de l’IA qui était embourbée dans des concepts qui l’enfermait. Ça a été une vraie révolution.

Et la prochaine révolution, c’est l’informatique quantique ?

J’y crois beaucoup. Elle utilise les propriétés infinitésimales de la matière, en particulier un phénomène quantique très difficile à concevoir, la superposition : une particule peut être dans plusieurs états simultanément. Cela peut paraître contre-intuitif. Au lieu d’avoir un interrupteur simplement ouvert ou fermé, cela revient à avoir un potentiomètre qui permet d’avoir l’ensemble des positions possibles, de totalement éteint à totalement allumé. L’objectif de l’informatique quantique est de pouvoir utiliser ce phénomène – il y en a plusieurs, mais c’est le principal – pour permettre de paralléliser les efforts. Prenons l’exemple de MIDI Maze (l’un des premiers jeux pratiqués sur ordinateur qui consistait à sortir d’un labyrinthe) : l’ordinateur classique va programmer un chemin pour voir s’il fonctionne et essayer les autres à la suite. On peut paralléliser le travail avec plusieurs ordinateurs pour qu’ils puissent explorer l’ensemble des chemins. Cela va être long. Avec un ordinateur quantique, on peut faire ce travail d’exploration de tous les chemins à la fois dans un temps exponentiellement plus court. On peut ainsi imaginer remplacer un certain nombre d’algorithmes par des algorithmes quantiques, donc exponentiellement plus courts. L’exemple qui a popularisé le quantique est l’algorithme de Shor, un algorithme de factorisation des nombres en nombres premiers : avec des très grands nombres, cela peut prendre très longtemps. Cette technologie est aujourd’hui utilisée dans le chiffrement : pour casser ces clés de chiffrement il faut un milliard d’années à un ordinateur classique. Avec un ordinateur quantique peu sophistiqué, il faudrait une centaine de secondes ! Si l’on est capable d’avoir un ordinateur quantique suffisamment gros, capable de passer à l’échelle, on change complètement le monde du calcul dans lequel nous vivons. Et pas qu’un peu ! On serait obligé de passer à un autre dispositif de chiffrement, car on pourrait par exemple déchiffrer tous les messages qui passent sur internet. Mais c’est aussi la possibilité d’explorer certains types de traitements, notamment chimiques, comme la capacité de créer un catalyseur afin de pouvoir capturer du CO². Si on en est capable, on pourrait résoudre la question du réchauffement climatique. Il s’agit bien plus qu’une hypothèse de travail et cela pourrait constituer la réponse à ce que l’on cherche. Mais si on n’y arrive pas, on s’oriente vers un monde absolument terrifiant. Ce genre de rêve, l’ordinateur quantique nous y donne accès.

À propos de Bernard Ourghanlian :

Bernard Ourghanlian a rejoint Microsoft France en 1999 au poste de Directeur Technique. Depuis le mois de novembre 2002, où il a été nommé Directeur Technique et Sécurité (Chief Technology & Security Officer) et Directeur de l’Entité Services par interim, Bernard Ourghanlian a la responsabilité de la conduite globale de la stratégie de Microsoft en France, en matière de technologie et de sécurité. Il a également en charge la gestion des risques technologiques de Microsoft France. Bernard Ourghanlian est membre du comité de direction de Microsoft France depuis le début de l’année 2009. Il est également administrateur du Syntec Numérique et de l’Université de Paris Sud. En liaison étroite avec la Direction Générale et les différentes entités concernées, il représente Microsoft France sur le plan technique auprès des principaux responsables gouvernementaux et des grandes agences gouvernementales, des directions informatiques, des comités de standardisation ou de normalisation ainsi qu’auprès du monde de l’éducation et de la recherche. Il est également en liaison étroite avec Microsoft Corporation, avec Microsoft Research et les différents groupes produits et participe activement à l’évolution des produits et des solutions de Microsoft. Il est membre du comité de direction du centre de recherche commun qui a été créé entre l’INRIA et Microsoft Research.

Avant de rejoindre Microsoft, il était le Directeur Technique de Digital France où il a participé activement à la conception et au développement de l’architecture des microprocesseurs Alpha et des différents éléments logiciels système permettant d’en assurer le support. Auparavant, il a participé à la conception et à l’implémentation des premières techniques d’imagerie par résonance magnétique nucléaire au sein de la société Thomson. Il a commencé sa carrière comme enseignant et chercheur à l’université d’Orsay. Il également est docteur en mathématiques et l’auteur de plusieurs ouvrages spécialisés relatifs aux statistiques et à l’informatique, notamment d’un ouvrage de référence sur les microprocesseurs Alpha.